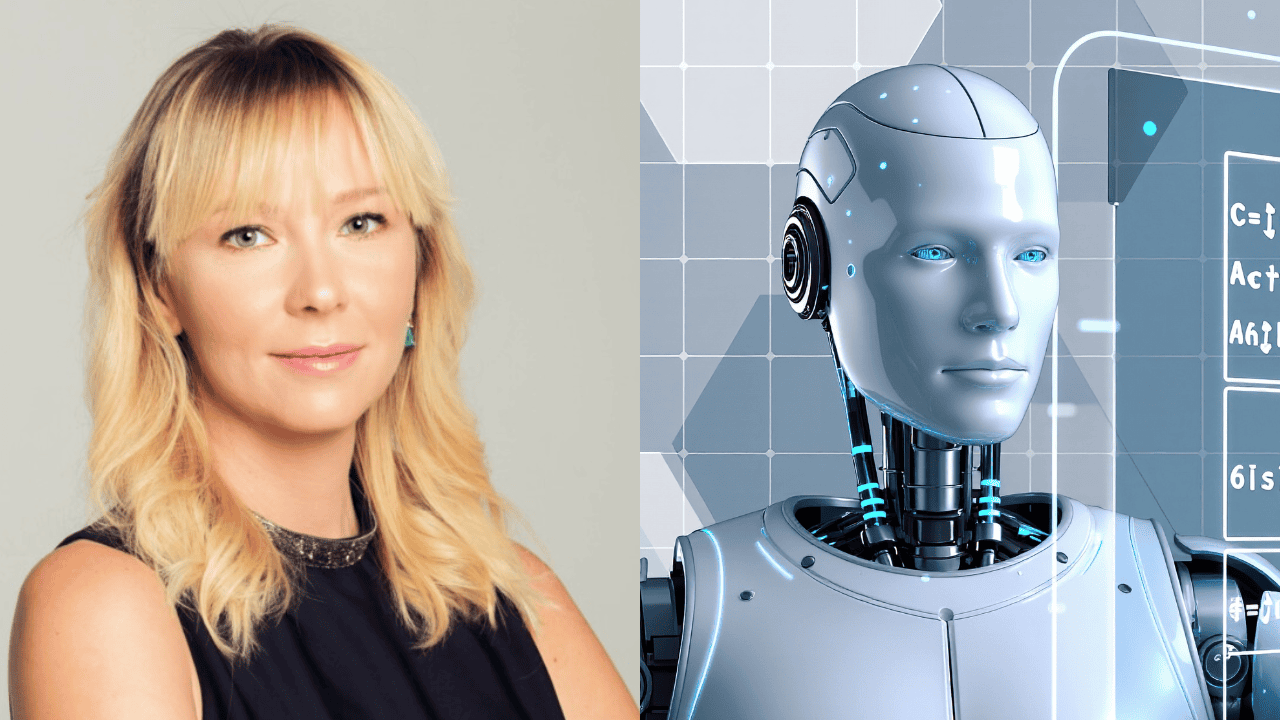

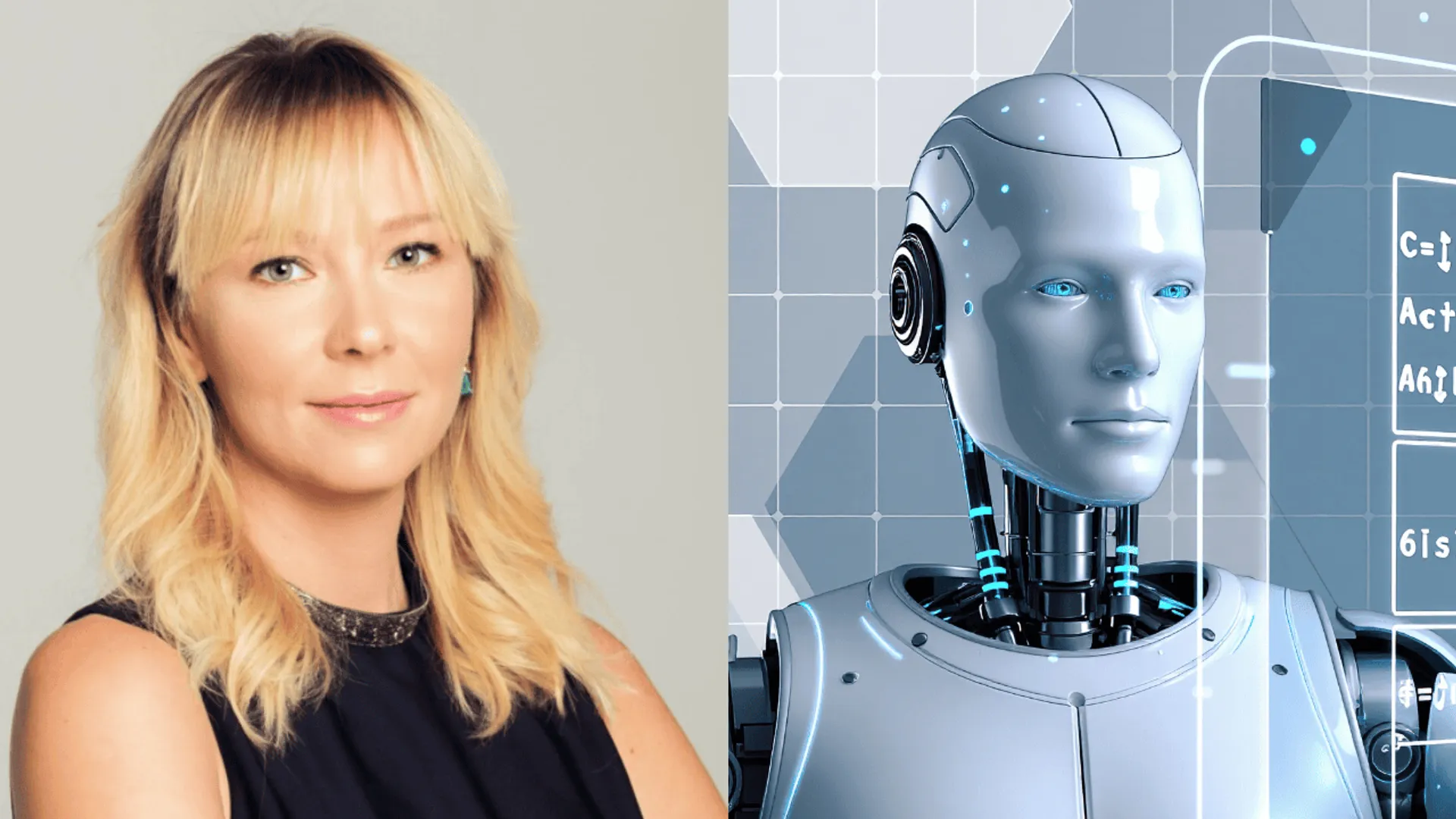

AI nie jest tym, czym straszą. Prof. Aleksandra Przegalińska z Harvardu studzi technologiczne lęki

Sztuczna inteligencja wdarła się do codzienności szybciej, niż zdążyliśmy ją oswoić. Dla jednych jest fascynującym narzędziem, dla innych – zapowiedzią utraty pracy, sensu twórczości i kontroli nad technologią. W rozmowie z Gońcem dr Aleksandra Przegalińska, badaczka nowych technologii związana m.in. z Harvardem, studzi emocje i przekonuje, że największym zagrożeniem nie są same algorytmy, lecz nasze wyobrażenia o nich.

Inteligencja bez ciała

Dzisiejsza sztuczna inteligencja radzi sobie znakomicie z analizą danych, obliczeniami i grami strategicznymi. W tych obszarach już dawno prześcignęła człowieka. Jednocześnie – jak podkreśla Przegalińska – pozostaje zaskakująco bezradna tam, gdzie dla ludzi oczywiste są ruch, percepcja i interakcja z otoczeniem.

– Są takie wymiary inteligencji związane z ciałem i percepcją, w których my – ewolucyjnie – jesteśmy zdecydowanie lepiej przygotowani – mówi Gońcowi badaczka.

Paradoks współczesnej technologii polega na tym, że potrafi ona rozwiązywać abstrakcyjne problemy szybciej niż człowiek, ale wciąż ma trudność z prostymi czynnościami fizycznymi, które wykonuje nawet dziecko. Robot, który bezbłędnie przeanalizuje miliony rekordów w arkuszu danych, nadal potyka się o nierówny chodnik.

Lęk przed maszyną

Strach przed sztuczną inteligencją jest – zdaniem Przegalińskiej – w dużej mierze dziedzictwem popkultury. Wizje znane z kina science fiction sprawiają, że technologia wydaje się autonomicznym bytem, zdolnym do przejęcia kontroli nad światem. Tymczasem AI coraz częściej działa w tle, stając się tak oczywista jak elektryczność czy internet.

– Wystarczy umieć rozmawiać, żeby skorzystać z ChatGPT – zauważa ekspertka.

Niepokój dotyczy przede wszystkim przyszłości pracy i relacji społecznych. Choć algorytmy już dziś pełnią rolę doradców, asystentów czy narzędzi terapeutycznych, nie są w stanie samodzielnie zastąpić człowieka w obszarach wymagających odpowiedzialności, empatii i rozumienia kontekstu.

Dlaczego młodzi mówią: „cringe”?

Jednym z bardziej zaskakujących zjawisk jest rosnący dystans młodego pokolenia wobec treści generowanych przez AI. Dla wielu nastolatków i młodych dorosłych sztuczna inteligencja stała się synonimem wtórności i braku autentyczności.

Algorytmy produkują obrazy, teksty i muzykę, które często są poprawne technicznie, ale pozbawione oryginalności. Młodzi dostrzegają, że AI nie tworzy niczego naprawdę nowego, lecz rekonfiguruje to, co już istnieje.

– Sztuczna inteligencja nie jest innowacyjna. Proponuje rozwiązania i metody, które wcześniej już się gdzieś sprawdziły – podkreśla dr Przegalińska w rozmowie z Gońcem.

W mediach społecznościowych coraz silniejsza staje się tęsknota za autentycznością i doświadczeniami „analogowymi”. Symbolicznym gestem były akcje zrywania plakatów reklamujących „przyjaciela AI” w Nowym Jorku – wyraz sprzeciwu wobec prób zastąpienia relacji międzyludzkich technologią.

Czy bańka AI pęknie?

Równolegle narasta sceptycyzm finansowy. W USA coraz częściej mówi się o możliwym pęknięciu bańki inwestycyjnej wokół AI. Ogromne nakłady na centra danych i infrastrukturę nie zawsze przynoszą spektakularne zyski. W wielu organizacjach wdrożenia sztucznej inteligencji kończą się jedynie kosmetycznym wzrostem efektywności.

Coraz więcej ekspertów – w tym Jan LeCun – sugeruje, że dominacja modeli językowych może być etapem przejściowym. Przyszłość ma należeć do tzw. fizycznej sztucznej inteligencji, czyli robotyki działającej w realnym, chaotycznym świecie.

Robot, który musi radzić sobie z pogodą, przeszkodami i nieprzewidywalnością otoczenia, staje przed wyzwaniami znacznie trudniejszymi niż przewidywanie kolejnego słowa w zdaniu. To właśnie tu może dokonać się kolejny technologiczny przełom – zwłaszcza w opiece nad seniorami, logistyce czy medycynie.

Prawo, dezinformacja i odpowiedzialność

Rozwój AI rodzi poważne problemy prawne. Modele językowe były trenowane na ogromnych zbiorach tekstów i dzieł kultury, często bez zgody twórców. Stąd rosnąca liczba pozwów, w tym głośna sprawa wytoczona przez „New York Timesa”. W przyszłości konieczne mogą okazać się nowe systemy tantiem, które wynagrodzą autorów za wykorzystanie ich pracy.

Osobnym wyzwaniem są deepfake’i, coraz częściej wykorzystywane do manipulacji politycznej i dezinformacji. Państwa – jak podkreśla Przegalińska – muszą inwestować w narzędzia weryfikacji treści, bo bez nich demokracje staną się podatne na masową manipulację. Przykładem stanowczej reakcji były Włochy, które po użyciu deepfake’a z udziałem premier Giorgii Meloni zaostrzyły przepisy karne.

Maszyna bez woli

Mimo gwałtownego rozwoju sztuczna inteligencja pozostaje narzędziem statystycznym. Nie ma świadomości, intencji ani własnych celów. Jej błędy – tzw. halucynacje – nie wynikają z chęci oszustwa, lecz z matematycznej logiki przewidywania najbardziej prawdopodobnej odpowiedzi.

– Żeby stać się „Terminatorem”, trzeba mieć wolę. To jest jeszcze poziom wyżej – tłumaczy Przegalińska.

Nawet ewentualne osiągnięcie tzw. sztucznej inteligencji ogólnej nie oznacza automatycznie narodzin świadomości. Paradoksalnie badania nad AI więcej mówią nam o ludzkim umyśle niż o maszynach – pokazują, jak złożone i wciąż słabo rozpoznane są procesy myślowe człowieka.

Człowiek w centrum

Największym zagrożeniem nie jest bunt maszyn, lecz utrata ludzkiej ekspertyzy. Bezrefleksyjne delegowanie zadań algorytmom może prowadzić do zaniku kompetencji, które budowaliśmy latami. Dlatego – jak przekonuje Przegalińska – kluczowe jest krytyczne myślenie i zachowanie sprawczości.

Sztuczna inteligencja może być potężnym narzędziem, ale tylko wtedy, gdy pozostanie pod ludzką kontrolą. To od decyzji podejmowanych dziś przez państwa, firmy i użytkowników zależy, czy stanie się wsparciem dla kreatywności i rozwoju, czy jedynie generatorem cyfrowego szumu.

Źródło: Goniec